Los sesgos en inteligencia artificial, el reflejo de una sociedad injusta

Joy Buolamwini, una científica informática, descubrió que su cara no era reconocida por un sistema de reconocimiento facial mientras desarrollaba aplicaciones en un laboratorio del departamento de ciencia de la computación de su universidad. Este es el punto de partida del recientemente estrenado documental Coded Bias. Buolamwini descubrió que los datos (caras) con los que entrenaron aquel tipo de sistemas eran principalmente de hombres blancos. Esto explicaba por qué el sistema no reconocía su cara afroamericana.

Nos gustaría poder reducir esta columna a este párrafo. Podríamos concluir que, como la inteligencia artificial (IA) la desarrollan principalmente hombres blancos, nadie se preocupó de que los datos fuesen representativos y que, para solucionar esos sesgos, debemos usar datos que incluyan a toda la población.

Lamentablemente, esta no es la conclusión correcta. Y, paradójicamente, para comprender el problema de esta tecnología puntera, debemos retroceder a un oscuro pasado. Lo que a Joy Buolamwini le pareció inicialmente una curiosidad y un error técnico, se convirtió en el descubrimiento de una dolorosa forma de dominación y opresión, traducida en nuevas formas de discriminación y racismo, que el documental desarrolla en su parte central.

Injusticias y discriminación

El racismo es una forma de opresión que se origina a partir de la clasificación de un grupo sobre otros, con el fin de dominarlos. Esa opresión se traduce en profundas injusticias estructurales que sufren los grupos excluidos y que limitan sus opciones y capacidades de desarrollo a través de dinámicas sociales, estereotipos culturales, estructuras jerárquicas y mecanismos económicos.

Como si fuesen dos caras de una misma moneda, los mecanismos que oprimen a unos permiten a los grupos dominantes el desarrollo de sus capacidades, otorgándoles una ventaja histórica y facultándolos también para abusar de sus privilegios. Estas injusticias se vuelven estructurales: tanto el racismo, como el clasismo o la discriminación de género son reinterpretados, evolucionan y se reproducen.

La clasificación, entonces, está en la esencia de construcciones sociales que son exitosos mecanismos de dominación y que no tienen ningún sustento científico, tales como la clase, el sexo binario o la raza (el ADN de dos seres humanos escogidos al azar es idéntico en al menos un 98,4 %).

Si se hubiese querido elegir un elemento clasificatorio que nos distinga sin generar un contenido opresivo, se podría haber usado la calvicie, el tamaño de los pies o cualquier otra característica. Sin embargo, clasificar a partir del color de la piel produce una separación simbólica entre superiores e inferiores, naturales y racionales. A esta se unen la condición económica y la significación social de ser mujer, entre muchas otras. Potenciadas interseccionalmente –pensemos en una mujer indígena pobre– causan profundas injusticias y discriminaciones.

Los algoritmos, un reflejo de la sociedad

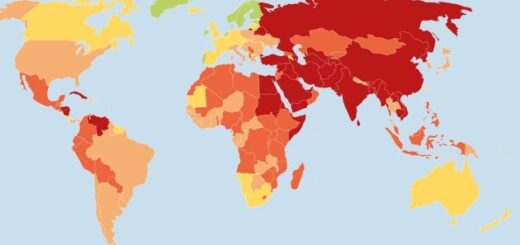

En este contexto, se ha comprobado que la IA usada en casos que se relacionan con complejidades sociales reproduce y amplifica las injusticias. Este es el caso de sistemas que predicen delitos y que en muchas ocasiones asocian delincuencia con racismo policial histórico.

También ocurre con sistemas predictivos que detectan, con un alto margen de error, fraudes en los beneficios sociales para personas vulnerables; o en sistemas de predicción de abuso infantil que discriminan pobreza; o en sistemas automatizados de contratación de personal estandarizados, arbitrarios y no representativos. A estos casos se suman ahora los sistemas de reconocimiento facial.

Por supuesto, es posible esbozar una explicación desde un punto de vista técnico, describiendo, por ejemplo, la falta de representatividad en los datos. Pero si hablamos de sesgos codificados y de reproducción de injusticias sociales, ninguna explicación técnica es suficiente.

Si bien es cierto que existen sesgos involuntarios o propios de las limitaciones técnicas de estas tecnologías, no debemos perder de vista que detrás hay personas que toman decisiones sobre qué diseñar, cómo y con qué propósito, y que en algunos casos los sesgos pueden ser intencionados. En ese sentido, la inteligencia artificial, usada en determinados contextos, puede no tener la objetividad y neutralidad que tendemos atribuirle.

«La biología no es el cuerpo, es el discurso sobre el cuerpo», dijo Donna Haraway, ya hace varias décadas, para evidenciar que la objetividad o neutralidad en el conocimiento científico es, al fin y al cabo, irreal. Todas las personas representamos parcialmente el mundo y la realidad que percibimos desde nuestro subjetivo punto de vista. El problema es que aquellos en posiciones estructuralmente superiores, toman estas representaciones parciales y las establecen como regla general. Así, por ejemplo, la biología, es un relato, conocimiento situado, desde la perspectiva de un grupo de personas que interpretaron y definieron el lugar y esencia del ser humano en la naturaleza y en la historia y lo establecieron como axiomas indiscutibles.

La inteligencia artificial, bajo una aparente objetividad, está situada, asimismo, en un contexto donde ha existido históricamente una brecha entre hombres y mujeres, además de la exclusión de grupos minoritarios. Por eso se diseña y desarrolla desde una perspectiva particular, de hombres blancos de élite, dado que son los que ocupan las posiciones más altas y decisivas dentro del campo de desarrollos tecnológicos.

Pues bien, donde existen relatos parciales impuestos, existen del mismo modo desigualdades sociales estructurales y la presencia de grupos privilegiados y discriminados.

► Continuar leyendo esta nota en: The conversation