Tecnología política

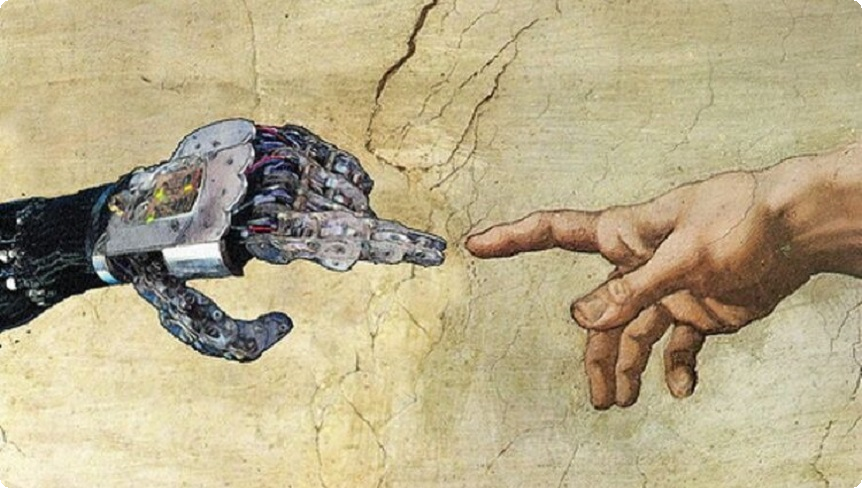

Desde los albores de la modernidad hasta la era de la inteligencia artificial, el pensamiento occidental ha sostenido un mismo impulso: la supremacía de la razón que separó la técnica del conocimiento. Ese paradigma, nacido con la Ilustración y hoy exhausto ante la complejidad digital, encuentra en la IA su respirador artificial. Entre los ecos del Renacimiento y los algoritmos de Silicon Valley, este texto recorre la historia de esa idea y muestra cómo nuevos actores —desde el feminismo hasta la tecnodiversidad— buscan repensar el vínculo entre saber, poder y tecnología desde América Latina.

UNO

La secuencia histórica que se origina con el proceso de industrialización y la Revolución Francesa junto a la expansión territorial del capitalismo, puso en marcha una complejización geopolítica, demográfica, tecnológica, económica y social con derivas jurídicas, institucionales, culturales y epistemológicas, que excedía largamente la capacidad de respuestas de la época. Por entonces la filosofía moral promovía la independización de la religión y aportaba los primeros fundamentos normativos para la conformación de los Estados modernos, pero le costaba despegarse de una concepción dicotómica, atada al bien y el mal, lo correcto y lo incorrecto, el deber y la virtud. Ese lastre la limitaba para interpretar, abordar y procesar la diversidad, el alcance, el apremio, y los niveles de afectación que presentaban los problemas emergentes. A partir de lo cual, se puso en marcha una reestructuración del saber donde se combinaron factores de poder con necesidades políticas, demandas institucionales y la inscripción filosófica del Renacimiento. De esa intersección surgió la clasificación de los campos del saber que consolidaron al positivismo científico y permitieron justificar el modelo de autoridad y de gobernanza que constituyeron a los Estados nacionales, surgidos con la Revolución Francesa y expandidos con las independencias americanas.

Ese diseño epistemológico-político logró desplazar a las monarquías y separar al Estado del poder eclesiástico, y también de cualquier otra noción de realidad última que no sea la razón. Es decir, consolidó a la era secular como un orden social con una axiomática laica; delimitó el mapa disciplinar de la modernidad que —con escasas variaciones— sigue estructurando las unidades académicas de la gran mayoría de las universidades del mundo en ciencias exactas, ciencias humanas, ciencias naturales y ciencias sociales; e instituyó a la cosmotécnica que todavía caracteriza al expansionismo nor-atlántico. Hoy, dos siglos y medio después, sabemos que la tecnología atraviesa todas las dimensiones de esa cartografía disciplinar, sin excepción; pero a pesar de esa consciencia, no ha podido trascender el estadio de la instrumentalidad y acceder al dominio científico.

La concepción reduccionista de la tecnología se remonta a la matriz logocéntrica de la antigüedad clásica, cuando la tekné (τέχνη) refería al saber práctico, y sus incumbencias a un único ámbito de pertenencia: la acción. Es decir: la doxa (δόξα), donde promiscuamente se mezclaban la opinión, el sentido común y las creencias; el submundo donde las ilusiones y las habladurías se asumían como ciertas o como si fueran la realidad misma. El reverso de la docta (σοφή) donde el conocimiento era el resultado de una fundamentación sistemática, metódica y rigurosa; donde el sentido estaba tutelado por la razón y el pensamiento meditativo; y donde, por cuestiones de principio, la corporeidad sintiente siempre estuvo convenientemente excluida. Los prejuicios que en la actualidad rodean a la cultura digital son heredados de esa tradición cosmovisional.

DOS

Ingresando a la segunda mitad del siglo XX, la persistente degradación ontológica de la tecnología llamó la atención del ingeniero francés Gilbert Simondon, quien en 1958 advirtió que la cultura dominante se ha constituido en un sistema de defensa contra la técnica, como si los objetos técnicos fueran ajenos a los humanos. Dos décadas después, la sociología, apoyándose en la teoría constructivista, presentó la perspectiva socio-técnica. Los trabajos de Wiebe Bijker, Michel Callon, Thomas Hughes, Bruno Latour, y Trevor Pinch, entre otros destacados representantes de esa corriente, hicieron que la tecnología perdiera el velo de aparente o pretendida neutralidad que la presentaba como un hecho científico, autónomo e independiente. A partir de allí, pasó a ser entendida como un actante que gravita activamente dentro de una red de relaciones, donde expresa y adquiere gravitación a través de la dinámica de sus interacciones y asociaciones. Consecuentemente, la técnica empezó a ser observada en un marco de relaciones que está indisolublemente vinculado a las alianzas socio-técnicas, los intereses sectoriales y los procesos de legitimación social que participan de la interacción. Seguir prescindiendo de las construcciones sociales que le dan sentido a las tecnologías hubiera significado ignorar el modo en que determinan ventajas, dominios y posiciones de acumulación. Hernán Thomas, un referente ineludible de la perspectiva socio-técnica en Argentina, fue uno de los que más hizo para aclarar que «la tecnología no es neutral, no es universal, no es lineal y no es evolutiva. La tecnología está situada, responde a grupos sociales y a intereses concretos».

Más recientemente, el filósofo e ingeniero informático chino Yuk Hui amplió esa perspectiva presentando a la «tecnodiversidad» y la noción de «cosmotécnica», interpelando la mirada «tecnocéntrica» de Occidente y exponiendo los múltiples prejuicios sobre tradiciones milenarias como la China, la hindú y nuestras propias culturas precolombinas.

Nada de eso ha sido suficiente, sin embargo, para detener —al menos por ahora— la antigua fuerza inercial que sigue presentando a la tecnología como autónoma respecto de los actores sociales, y por lo tanto como una ajenidad sobre la que se proyecta una amenaza constante. Basta con ver lo que reproducen Hollywood, la ciencia ficción y la literatura distópica, haciéndose eco de estos imaginarios; pues, aunque no los crearon ni son responsables de esa construcción social, en muchos casos funcionaron como sus mediadores culturales.

TRES

La agenda social está incluyendo, cada vez con más frecuencia, a filósofos que alertan sobre los riesgos que conlleva el desarrollo de la IA, y a cientistas sociales denunciando la homogeneización cultural que perpetra el ChatGPT universalizando un sesgo blanco, patriarcal y nor-occidental que desconsidera al resto de las cosmovisiones, del mismo modo que estigmatiza barrios populares, etnias, desigualdades estructurales de género y religiones alternativas. Nadie diría que no son misiones encomiables o que no inspiran admiración, por el modo en que generan conciencia social sobre los riesgos a los que nos enfrentamos como sociedades. Especialmente en un mundo que se revela temerario, sino extraviado. Pero tampoco deberíamos olvidar que la filosofía es algo más que expresar miedos e infundir desesperanza social cada vez que se percibe un futuro oscuro. Si no Copérnico, Pico della Mirandola y Giordano Bruno jamás hubieran arremetido contra la oscuridad del orden medieval. Su osadía fue fundamental para que se abriera el camino, primero del Renacimiento, después del sujeto cartesiano y posteriormente de la reconfiguración político-económica que sobrevino secuencialmente con el Contrato Social, la Revolución Industrial, la Revolución Francesa, la creación de los estados liberales y las democracias modernas.

En el mismo sentido, tampoco deberíamos olvidar que las Ciencias Sociales surgieron con el afán de generar marcos analíticos que permitan descifrar las formas del transcurrir común; pero también de identificar y visibilizar situaciones socialmente generalizables, sobre todo aquellas que son reprimidas, desoídas o desalentadas por el discurso hegemónico, lo cual —por supuesto— no ocurre sin una sintonía sensible con la experiencia social.

Kant, adelantándose al entusiasmo futurista y a la pretensión omnicomprensiva de la Ilustración, decía que una sociedad alcanza la mayoría de edad cuando se sirve de su propio entendimiento para pensar el modo en que va a habitar el mundo —lo cual, por supuesto, incluye la consideración de los efectos de ese estar en el mundo. En la sociedad informacional ese desafío implica —entre otras cosas— deconstruir la idea que tenemos de sociedad, de conocimiento y de tecnologías. Es decir, del modelo de poder y de convivencia que viene versionando el mundo desde hace varias generaciones: con un relato supremacista de la especie humana; con el amonedamiento de lo sensible (lo cual incluye la performación de los cuerpo y la instrumentalización del universo afectivo); con el positivismo científico como forma de dominación epistémica con pretensión universalizadora; con una dependencia de la racionalidad logocéntrica que hoy obtura una resignificación del mundo de la vida; y, por supuesto, con la degradación ontológica y política de la técnica. Ahora veamos dos actores que, desde distintos lugares, rompieron estas barreras epistémico-políticas.

El feminismo es uno de los actores sociales que lidera esa deconstrucción. Lo hace cuestionando y exhibiendo los cimientos patriarcales que siguen vigentes en la mayoría de las culturas actuales. De hecho, hoy compone un complejo actor global y multicultural que intersecciona diferentes acciones colectivas: advirtiendo sobre los riesgos de seguir contaminando el planeta, denunciando las desapariciones que produce el narcotráfico, repudiando los encarcelamientos por aborto, pidiendo que no las golpeen más. A contramano de una institucionalidad que sigue desoyéndolas, las mujeres construyeron su propia agenda y con el hashtags #niunamenos sacaron millones de personas a las calles e intervinieron la agenda mediática, política, legislativa, cultural y judicial. Utilizaron la nueva gramática tecnosocial para expresar una voluntad colectiva y transversal. Mientras tanto, hay que decirlo, la que brilla por su ausencia frente a esa interpelación, es la agenda de los varones. Pero sigamos…

Simondon, Deleuze y Guattari, Flusser, Lévy, Stiegler y los representantes de la perspectiva socio-técnica conformaron un actor que, de manera escalonada, viene cumpliendo un rol análogo en el ámbito científico-académico. Puede parecer una comparación forzada, pero fue realmente importante la tarea que realizaron identificando y reconociendo que la tecnología funciona como una reticularidad transversal en lugar de «ser» una mera instrumentalización del mundo sin reflexividad. Sus exploraciones rompieron la endogamia científica y lograron acompasar la experiencia técnica con el mundo de la vida. Son la contracara efectiva, tanto del tecnooptimismo ramplón como del solucionismo tecnológico que vende Silicon Valley.

CUATRO

En este marco, lo que llamamos Inteligencia Artificial se parece más a un manotazo resiliente del logocentrismo, que a una innovación epistémico-cognitiva. Analicemos por qué. Los Grandes Modelos de Lenguaje (LLM) —la Inteligencia Artificial General es sensiblemente diferente— son motores de inferencia estadística que están entrenados para reconocer y generar patrones complejos a partir de los datos existentes, que proceden de toda la producción textual humana. Digamos que funciona como una máquina probabilística capaz de realizar procesamientos masivos con billones de operaciones por segundo. Ese es el mecanismo que le permite componer las respuestas para los usuarios en un lapso de tiempo muy breve, inusitado. Ahora bien, si a esto lo despojamos de las hipérboles y del pensamiento mágico que suelen recubrir a la Inteligencia Artificial, lo podríamos describir como un refinamiento de la operatoria comparación-clasificación que históricamente caracterizó al logocentrismo y que hoy lo reafirma como él dispositivo de ordenamiento, jerarquización y construcción de sentido social. En definitiva, se trata de un procedimiento maquínico que extiende, perfecciona, potencia y consolida la arquitectura de sentido binario-patriarcal que es constitutiva del logocentrismo, justo en el momento que su montaje cosmovisional atravesaba una crisis significativa. En ese sentido, el logocentrismo pasó de estar con respirador artificial a tener una Inteligencia Artificial que lo mantiene vivo y funcional. ¿Por qué decimos que el logocentrismo estaba en una situación cuasi terminal y que ahora, mediante la IA, consiguió una prórroga de vida? Porque su andamiaje epistémico, como en el siglo XVIII, tiene serias dificultades para ofrecer respuestas y construir un horizonte de sentido efectivo, pero esta vez ante la complejización que sobrevino con el orden informacional. Me refiero a las serias limitaciones de la razón como principio de inteligibilidad y sustento modélico de organización social, tanto para gestionar la escala demográfica que se agolpa en las zonas urbanas de nuestro planeta (en 2025 es el 58,1%), como para administrar el escenario socio-técnico que se desplegó con la cultura digital. También me refiero a los obstáculos de la cultura enciclopédica —también académica— para pensar un proyecto crítico – emancipador alternativo, que trascienda el modelo de la Ilustración. Esto es un desafío y una oportunidad para la Filosofía y las Ciencias Sociales, tanto para trascender el estadio de diagnosticación como para generar conocimientos socialmente válidos. Veámoslo en cosas concretas.

Así como a comienzos de los noventa, la CEPAL intentó poner en marcha una Transformación Productiva con Equidad (TPE) ante la caída del muro de Berlín y el advenimiento de un mundo global, este es un buen momento para explorar y profundizar LatamGPT. En sintonía con lo que plantea el Manifiesto tecnopolítico de Biset, Blanco y Costa, la posibilidad de tener un modelo de lenguaje de código abierto, gratuito, colaborativo y hecho en América Latina, con la participación de universidades y gobiernos de toda la región, es un acontecimiento socio-técnico relevante, estratégico y visionario. Porque, así como no desaparecieron los mitos en el pasaje de la cultura oral a la escritura, tampoco desaparecerá el logos ni su relevancia individual, social, cultural y productiva en el tránsito hacia la cosmovisión que vaya a reemplazarla. Y porque en un proceso de complejización y transfiguración como el que atravesamos, se alteran todas las categorías orientativas que fueron desarrolladas bajo el marco epistémico de la modernidad y que hoy siguen naturalizadas; del mismo modo que se reconfiguran las categorías, los métodos y los criterios de validación que utilizamos para interpretar la realidad y producir conocimiento socialmente válido. Un ejemplo: lo que entendemos por política, junto a todo lo que designa la palabra política, debe revalidar socialmente sus incumbencias, igual que su fundamento teórico y sus formas de representación. Lo cual hace que la administración de lo común se vuelva particularmente desafiante, tanto para comprender como para actuar en este tiempo.

En ese contexto, una IA latinoamericana donde dispongamos de todo aquello que fuimos y somos, con los universos epistémicos de las cosmovisiones precolombinas, con el repertorio de saberes populares que nos mantuvieron en pie durante los últimos quinientos años, es un reservorio que los padres del decolonialismo hubieran anhelado y agradecido. La idea, dice Álvaro Soto, Director del Centro Nacional de Inteligencia Artificial en Chile (Cenia), es que cuando le preguntemos a LatamGPT sobre temas relevantes para nuestra región, sus respuestas sean acordes a lo que fuimos y lo que somos. Para poder abordar, analizar y ubicarnos en el actual reordenamiento del mundo en base a teorías, metas, estrategias, saberes, prácticas, tradiciones y formas resolutivas que estén referenciadas en Latinoamérica. Es casi un plan de sinceramiento, para devolver a Europa las sombras, porque es su lugar de origen, y el futuro distópico a EE. UU., porque es su promotor, su beneficiario y su dependiente. Visto de esa manera, también se convierte en una oportunidad para repensar nuestra educación.

CINCO

En nuestro país, la educación a distancia fue un campo que debido a su vínculo con la tecnología, la logística y la ubicuidad, convirtió a las tecnologías en un objeto de estudio que ayudó a superar prejuicios y a desarrollar una inflexión crítica acerca de su uso y su concepción. El desarrollo teórico de Edith Litwin y Beatriz Fainholc sobre la tecnología educativa, contra la fetichización, el determinismo y la visión instrumentalista de la tecnología, surgió de allí. Lo mismo que la pléyade de investigadoras que las sucedieron y que, en esa línea, siguen produciendo trabajos fundamentales. Pero la masificación de las tecnologías informacionales y la rápida asimilación social de la IA plantean otro tipo de desafíos para la educación.

El estrecho vínculo de los jóvenes con las tecnologías informacionales permitió el desarrollo de saberes tecnosociales que resultan fundamentales para interactuar en la sociedad actual y que, en términos de Emilia Ferreiro, configuran un nuevo objeto cultural. No sólo porque tiene valor de uso social, surge del esfuerzo colectivo y se adquiere a través de la interacción social, sino también porque gravita de manera decisiva en el mundo de la vida. Más aún: gravita en la composición del orden poslogos. Todo lo cual implica una dimensión socio-técnica que interpela al campo educativo desde otro lugar.

Por ejemplo, frente a la adopción de la gramática hipertextual que usamos para navegar Wikipedia o para postear en cualquier red social, ¿el sistema educativo debe seguir concentrando esfuerzos en la comprensión lectora de los pibes o, en paralelo, debería componer un método de lectocomprensión digital, interfásica e informacional?, ¿debe seguir reproduciendo una formación lineal, contenidista, memorativa y profesionalizante en un contexto donde todo eso puede ser fácilmente reemplazado por el ChatGPT? El avance informacional está incitando a la escuela a identificar los desafíos epistemológicos que plantea la cultura digital y a generar estrategias metacognitivas que provoquen una autorreflexión guiada sobre el alcance, la aplicación y las derivas —sociales e individuales— del nuevo objeto cultural y de la IA. Porque si bien la lectoescritura no ha perdido vigencia ni importancia, existe una narrativa emergente que está ampliamente asimilada, tanto en términos sociales como productivos y culturales.

En este sentido, por trágico que suene, la educación actual sólo tiene futuro si —con el apoyo de un Estado resignificador— genera las condiciones de posibilidad para una reflexión crítica y deconstructiva de la técnica; si se aviene a un debate con las juventudes sobre la sociedad que queremos.

* Nota publicada originalmente por Supernova, que reproducimos aquí con autorización del autor.

Fernando Peirone

Doctor en Estudios Sociales de América Latina (Línea Sociología), del Centro de Estudios Avanzados (CEA), de la Universidad Nacional de Córdoba. Docente e investigador de las universidades nacionales de San Martín (Unsam) y José C. Paz (Unpaz). Director del Observatorio Interuniversitario de Sociedad, Tecnología y Educación (Oiste).

LEÉ TAMBIÉN

Martín Becerra: «Internet pasó de la promesa democrática a un modelo de concentración y opacidad»

POR ESFERA REDACCIÓN | En la cuarta entrega de Polarizados, el nuevo podcast de la Universidad Nacional de San Martín (Unsam), Iván Schuliaquer mantuvo una extensa entrevista con Martín Becerra en la que repasan los grandes dilemas que atraviesa la comunicación contemporánea, desde la frustrada promesa democrática de internet hasta la irrupción de la inteligencia artificial. Becerra es profesor universitario, investigador del Consejo Nacional de Investigaciones Científicas y Técnicas (Conicet) y referente en estudios sobre medios y plataformas.

El proyecto tecnolibertario de Silicon Valley y Milei es una amenaza para una democracia soberana

POR ALFREDO MORENO | La inteligencia artificial ofrece un enorme potencial para fortalecer políticas públicas y optimizar recursos, pero su uso sin control democrático implica ceder soberanía a algoritmos diseñados bajo lógicas de mercado del norte global.

La mano invisible de las «big tech»: Cómo los gigantes tecnológicos desafían la capacidad regulatoria de los Estados

POR ESFERA REDACCIÓN | Con ingresos que superan el PIB de varios Estados, empresas como Meta, Alphabet, Amazon, Microsoft, Apple y ByteDance despliegan estrategias globales para influir en leyes, gobiernos y opinión pública. Una investigación del Centro Latinoamericano de Investigación Periodística (CLIP), junto con Agencia Pública (Brasil) y quince medios aliados, revela cómo las grandes tecnológicas buscan evitar las regulaciones que mitiguen sus efectos negativos sobre la sociedad y la política.

Comunicación: la batalla más brava

LUIS LÁZZARO | Es hora de que los espacios de representación del campo popular pongan en agenda y empiecen a hablar de la batalla cultural y comunicacional para hacer lugar al proyecto político que ponga límites a la catástrofe social y económica de la Argentina de Milei y que haga posible una distribución de la palabra para fortalecer la democracia.

La democracia en el filo: cuando el poder se disfraza de normalidad

POR MARCELO VALENTE | Las democracias contemporáneas atraviesan un momento de vulnerabilidad que no se explica ya por los viejos fantasmas del siglo XX —golpes, dictaduras, restauraciones—, sino por un proceso más sutil: la erosión interna del orden liberal bajo sus propias reglas. En distintos registros, Steven Levitsky y Lucan Way, Adam Przeworski y Quinn Slobodian coinciden en que la amenaza actual no proviene de un enemigo externo, sino de una transformación silenciosa del vínculo entre Estado, mercado y ciudadanía. La democracia, advierten, puede persistir como forma mientras pierde su sustancia.